这是我的第349篇专栏文章。

生成式人工智能GenAI是否存在泡沫?这个问题日益成为业界热议的焦点。目前,全球对AI基础设施的投资已到了癫狂的成千上万亿美元的规模,然而大模型如何实现盈利却始终没有一个明确的答案。

在众说纷纭之际,有一个领域的潜力却常常被低估,那就是边缘侧的人工智能(Edge AI)。作为一个方兴未艾的领域,边缘AI与云端AI可谓迥然不同。那些在数据中心行之有效的方法,不一定能够适用于工业边缘平台,如安全摄像头、机械臂或汽车等场景。

由于空间限制、功耗、预算、数据安全以及实时性等要求,边缘AI领域没有一刀切的解决方案。这意味着,没有任何一种方案能够满足所有人工智能应用的需求,从云端AI过渡到边缘AI需要开发全新的模型。

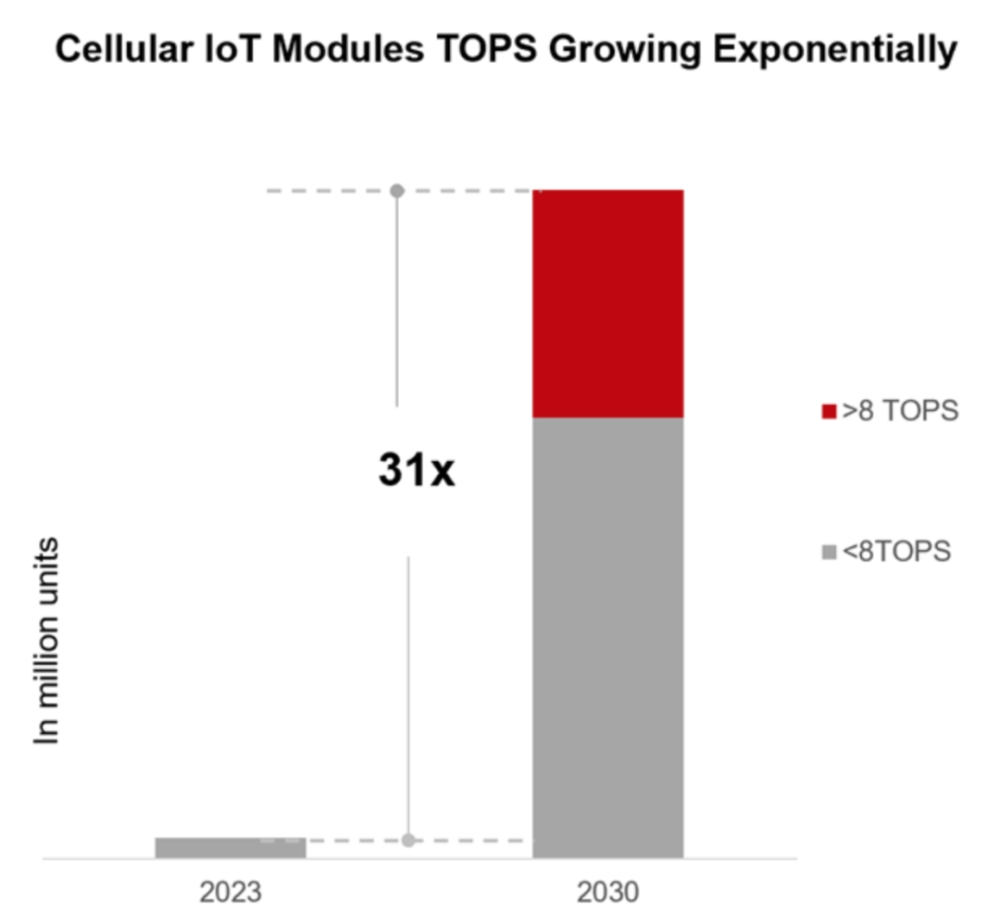

研究机构Counter Points的数据显示,未来AIoT模块的计算能力将实现指数级的大幅增长。据测算,未来七年内配备神经网络处理单元NPU的模块数量将达到目前的31倍,这将催生大量创新应用的涌现。

面对如此蓬勃发展的边缘AI市场,本文将对其进行深入剖析。笔者认为,边缘AI的崛起将催生出全新的商业模式,而去中心化物理基础设施网络DePIN或许是帮助边缘AI避免盈利困境的有效解决方案之一。

TinyML、SLM与LLM:联合语言模型的“三驾马车”

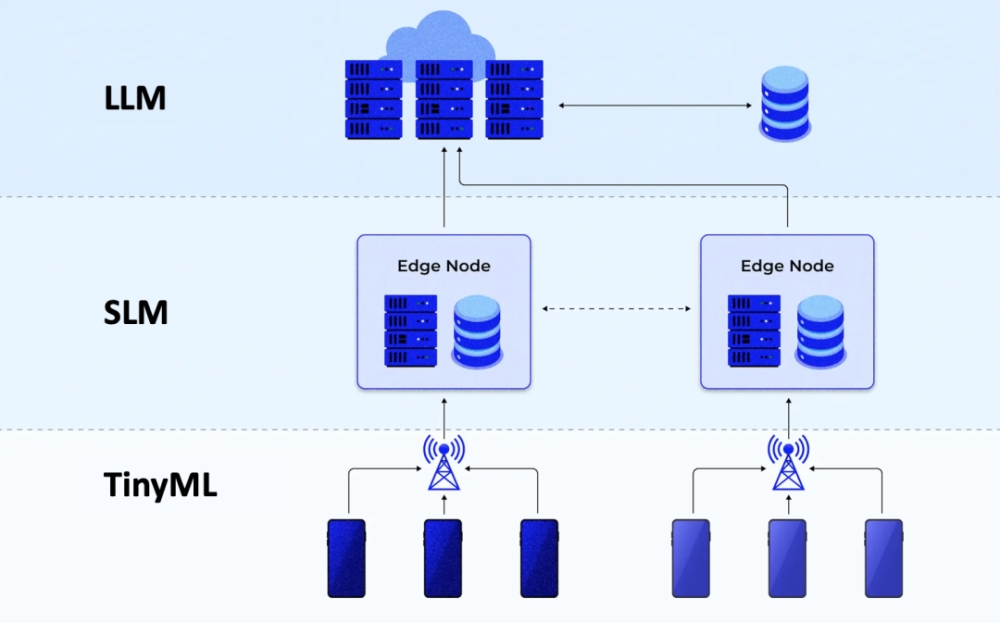

在人工智能的世界里,终端侧、边缘侧和云端扮演着截然不同的角色。它们在形态、功能和应用场景上的差异如此之大,以至于可以将其视为完全不同的实体。

正是基于这种认识,有业界人士提出了“联合大模型”的理念,旨在将不同规模的AI模型分别部署于云、边、端三个层面,以执行相关任务。

在终端侧,微型机器学习(TinyML)正在崛起。TinyML是一种优化机器学习模型的技术,使其能够在资源受限的设备(如微控制器)上高效运行。这些模型通常体积小巧、运算高效,能够胜任语音识别和传感器数据分析等任务。

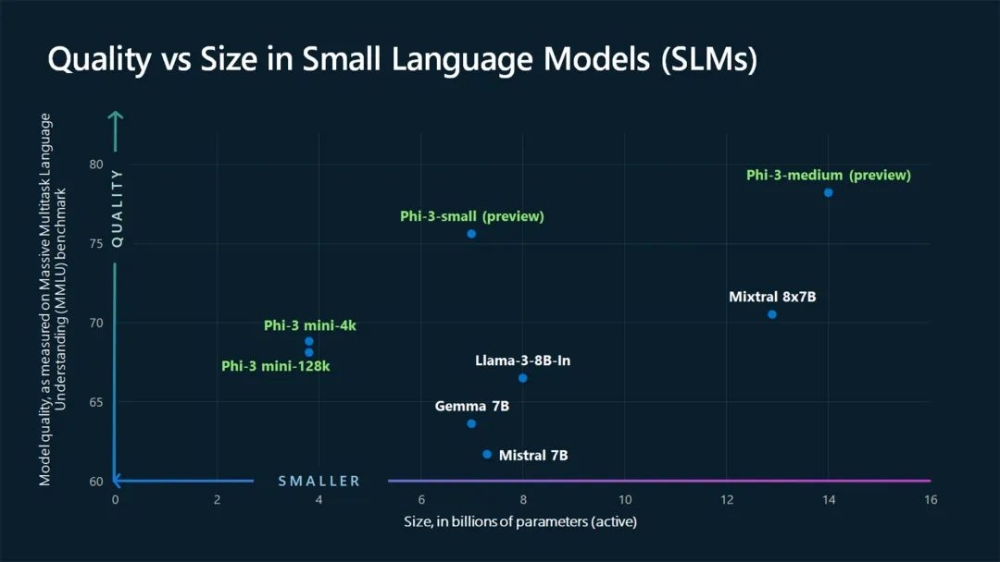

边缘侧的主角则是小型语言模型(SLM)。SLM指的是那些参数量低于100亿的轻量级神经网络模型。与大型模型相比,SLM以更少的参数和计算资源实现自然语言处理(如下图所示)。此外,SLM通常是面向特定任务、应用或用例量身定制的。

至于云端,大型语言模型(LLM)无疑是其中的佼佼者。LLM是一种强大的深度学习算法,能够执行各种自然语言处理(NLP)任务。得益于海量训练数据和多个Transformer模型的使用,LLM具备了识别、翻译、预测乃至生成文本等内容的惊人能力。

“联合语言模型”的提出,正是为了充分利用TinyML、SLM和LLM这三种技术,在保障隐私性和安全性的同时,为企业带来切实价值。

TinyML以其超低成本和功耗的特点,非常适合在资源有限的设备(如物联网终端和可穿戴硬件)上使用。

而SLM可以看作是LLM的“迷你版”。相比动辄数百万、数十亿参数的GPT-4等大型模型,SLM的运行规模要简单得多。经过优化的SLM能够高效处理较为简单的任务,而无需消耗大量计算资源。

尽管规模不及LLM,SLM在实际应用中却有着不可小觑的作用。从文本生成、问答到语言翻译,SLM能够胜任多种任务,只是在准确性和多功能性上可能稍逊一筹。

SLM的优势还体现在其训练速度快、推理速度佳等方面。它在性能和资源效率之间取得了微妙的平衡。参数数量的减少,使得SLM的训练更加经济高效;而将处理工作负载转移到边缘设备,则进一步降低了基础设施和运营成本。

BrainChip公司的实践表明,综合利用TinyML和SLM能够取得显著成效:模型参数数量减少50倍,训练时间缩短30倍,多重累积运算(MAC)降低5000倍,而精度却保持不变甚至有所提高。性能和功耗效率的提升与模型效率成正比。

Tirias Research预测,如果到2028年,使用边缘设备和终端硬件内的TinyML和SLM混合处理,从数据中心卸载20%的LLM工作负载,那么数据中心基础设施和运营成本将下降150亿美元,整体功耗需求也将降低800兆瓦。

从云端到边缘:GenAI迁移的必经之路

随着人工智能技术的不断发展,越来越多的AI模型开始从云端数据中心向边缘设备迁移。这种趋势的背后,是成本、实时性和安全性等因素的综合考量。

在云端运行AI模型,尽管能够利用数据中心强大的算力资源,但往往面临着高昂的费用、网络延迟和数据安全隐患等问题。相比之下,通过模型压缩等优化技术,将神经网络模型部署在网络边缘设备上运行,即边缘计算,则有望在保证性能的同时,大幅降低成本和延迟,提高数据安全性。

然而,对于许多边缘应用场景而言,简单地将数据中心的解决方案“缩小”并非最佳选择。在医疗保健、汽车、制造等关键领域,边缘AI应用通常专注于传感器数据的实时处理,对模型的尺寸、精度和执行效率有着更高的要求。

这就催生了“EdgeGenAI”的概念,即在设备上执行的生成式AI。越来越多的硬件展示了EdgeGenAI的能力,高通、英伟达等芯片厂商纷纷展示了在移动端运行Stable Diffusion、LLaMA等模型的可能性,这预示着EdgeGenAI已经到来。

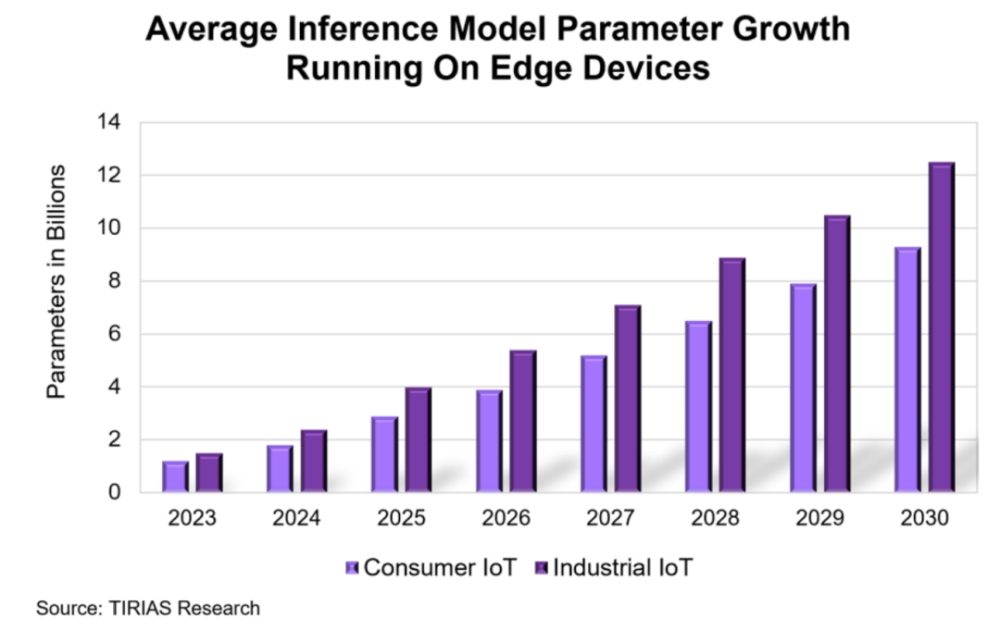

根据Tirias Research的分析,随着AI模型的不断压缩优化以及终端和边缘设备算力的持续提升,越来越多的GenAI模型将能够在设备端完成推理和执行。这意味着,适用于端侧处理的模型规模将随时间推移而不断增加,设备本地的AI处理能力将不断拓展。

与此同时,消费类和工业物联网设备所承载的平均推理模型参数规模也在不断增长。为了评估GenAI的发展前景和总体拥有成本TCO,Tirias Research对不同类别的设备进行了细分和建模,如下图所示。

研究发现,在设备本地处理AI任务,不仅能够显著降低响应延迟,提升用户体验,还能够有效缓解数据隐私和安全问题。通过减少或消除与云端的数据交互,敏感数据和GenAI生成的结果都能够在设备层得到妥善保护,大大降低了隐私泄露和网络攻击的风险。

不过,并非所有GenAI应用都适合完全在设备上处理。受限于芯片算力、内存容量和功耗预算,许多大型模型仍然无法在单个设备上高效执行。

针对这一问题,“联合大模型”的提出恰逢其时。

通过在设备与云端之间合理分配计算任务,这种混合计算模式能够在降低延迟、保护隐私的同时,充分利用云端的算力优势。

例如,在图像生成应用中,初始图像可以在设备上快速生成,而后续的增强和优化则交由云端处理。在需要整合多源数据的场景,如实时地图更新,将本地信息与云端模型结合也能发挥协同效应。某些涉及专有数据的行业应用,如工业和医疗领域,出于安全考虑,也可能需要在云端完成部分敏感计算任务。

据此,边缘AI有望迎来爆发式增长,据Counter Point预测,到2030年,搭载AI算力的物联网模块将占整体出货量的25%,远高于2023年的6%。

在汽车领域,AI助手通过语音交互、导航引导和娱乐控制,正在重塑自动驾驶体验;在零售行业,搭载AI模块的智能POS终端凭借掌纹或人脸识别、行为分析等能力,助力客户洞察、库存管理和风险防控;在智能家居场景,集成AI功能的路由器有望成为照明、安防、能源管理等子系统的中枢。此外,无人机、工业手持设备、服务机器人等领域,也将成为边缘AI芯片的主要应用阵地。

DePIN赋能边缘AI,开创盈利新模式

在人工智能的商业化进程中,大型语言模型(LLM)的盈利之路一直备受关注。

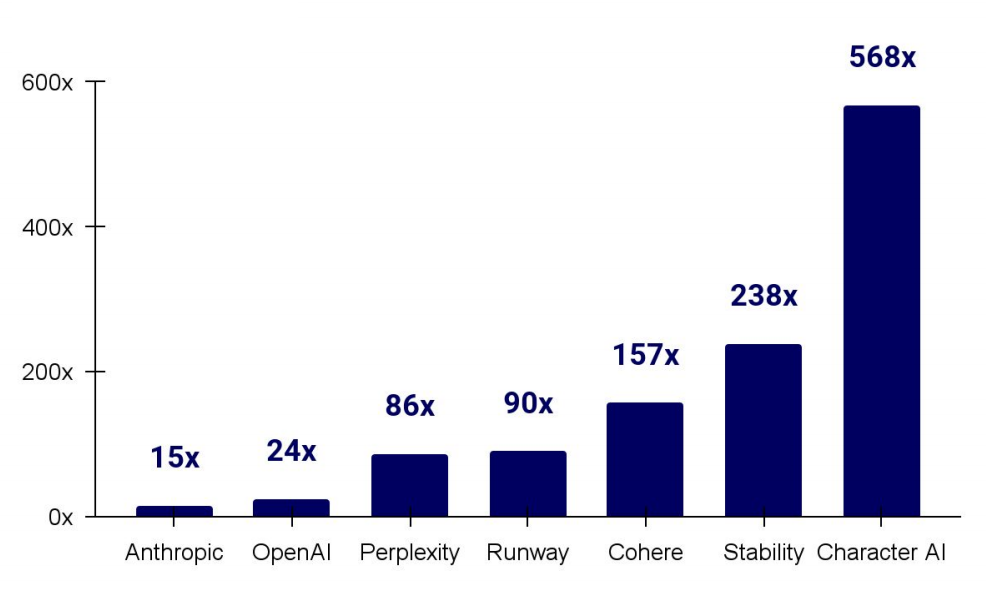

尽管生成式AI初创企业频频获得高额融资,估值屡创新高(如下图所示),但如何将技术优势转化为持续稳定的收入,仍是一个悬而未决的难题。

与此同时,随着AI模型不断向边缘迁移,嵌入式AI设备的市场需求正在快速增长。在这一背景下,去中心化物理基础设施网络(DePIN)与边缘AI的结合,有望为这一难题提供一个全新的解决思路。

DePIN的核心理念,是通过区块链技术和token经济,将分散在全球各地的物理设备连接起来,形成一个去中心化的资源共享网络。在这个网络中,设备所有者可以将闲置的计算、存储、带宽等资源出租给需求方,从而获得token激励。而需求方则可以以更低的成本、更高的灵活性,获得所需的基础设施服务。

如果将DePIN的模式引入边缘AI领域,可以极大地促进AI设备的普及和应用。

一方面,设备制造商可以通过融入DePIN社区,将AI设备预置到去中心化网络中,以资源共享的方式销售设备使用权,而非一次性售卖硬件产品。这种“设备即服务”的模式,将大大降低用户的前期采购成本,提升边缘AI的易用性。

另一方面,AI模型提供商也可以利用DePIN网络,将训练好的模型以API的形式提供给设备所有者,并按照调用量获得token收益。这种按需付费的机制,将显著降低边缘AI的推理成本,使中小企业和个人开发者也能够负担得起高质量的AI服务。

某宠物智能项圈厂商的案例,为DePIN赋能边缘AI提供了一个生动的例证。该厂商计划将智能项圈引入DePIN社区,构建一个去中心化的宠物数据共享网络。凭借项圈内置的活动监测和定位跟踪功能,海量的宠物行为数据将被采集和流转,成为宠物AI模型训练的重要数据源。而宠物主人则可以选择性地共享这些数据,并获得token激励。

这一去中心化AI范式,不仅能够显著提升数据处理的实时性和隐私性,更能够为宠物AI模型的开发和优化提供源源不断的数据支持。

与此同时,该厂商还计划开放项圈的边缘算力,允许第三方开发者将宠物AI模型部署到项圈中,实现场景化的AI应用,如异常行为检测、情绪识别、安全区域预警等。这种“AI即插即用”的开放生态,将极大地释放边缘AI的想象空间,催生出一批以宠物为中心的创新应用和服务。

DePIN与边缘AI的结合,不仅为设备制造商开辟了新的销售渠道和盈利模式,也为AI企业搭建了一个海量数据聚合、模型快速部署的去中心化基础设施。

写在最后

随着TinyML、SLM等技术的成熟,AI模型正在从云端向边缘大规模迁移,催生出EdgeGenAI等全新的应用形态。通过模型压缩、混合计算等优化手段,百亿级参数模型已经能够在智能手机等终端设备上高效运行。在万物智联的时代,边缘AI将为汽车、零售、家居等行业赋能,创造巨大的商业价值。

不过,当前的边缘AI生态仍面临着设备成本高、开发门槛高、盈利模式单一等挑战。去中心化物理网络DePIN的引入,有望通过将AI设备接入资源共享网络,建立按需付费机制,构建开放生态,从而有效破解边缘AI的商业化困局。

参考资料:

Federated Language Models:SLMs at the Edge + Cloud LLMs,作者:Janakiram MSV,来源:thenewstack.io

Tiny but mighty:The Phi-3 small language models with big potential,作者:Sally Beatty,来源:微软